Im Rahmen unserer Themenreihe „KI in der Bildung“ haben wir bereits an mehrere Stellen deutlich gemacht, dass Künstliche Intelligenz durchaus über das Potenzial verfügt, die Gesellschaft grundlegend zu verändern – positiv wie auch negativ. Aus diesem Grund muss KI unbedingt entsprechend ethischer Standards programmiert- und daran ausgerichtet werden.

Das Beispiel des autonomen Fahrens zeigt, dass KI einerseits das Potenzial birgt, Verkehrsunfälle um bis zu 90 Prozent zu reduzieren. Auch wenn damit Verkehrsunfälle stark reduziert werden können, bleiben sie dennoch, trotz des automatischen Fahrens, unvermeidbar. Die Frage nach der Schuld erscheint in solchen Fällen jedoch umso dringlicher: Wer ist verantwortlich, wenn die KI im Auto selbst einen Fehler macht? Was passiert, wenn eine Kollision z.B. mit einer schwangeren Frau oder einem älteren Ehepaar unvermeidbar ist? Wer entscheidet in diesem Fall und wer haftet?

Dieses hohe Konfliktpotenzial macht das autonome Fahren zum Paradebeispiel für den Zusammenhang zwischen KI und Ethik. Doch auch in vielen anderen Lebensbereichen ist eine Orientierung der KI entlang ethischer Richtlinien von Nöten. Deshalb gilt grundsätzlich: Wer sich mit Künstlicher Intelligenz beschäftigt, kommt um Fragen der Ethik nicht herum. Aus diesem Grund möchten wir das Thema „KI und Ethik“ in diesem Blogbeitrag von unterschiedlichsten Perspektiven aus betrachten.

Allgemeines zum Verhältnis von KI und Ethik

Die Ethik, die sich mit KI-basierten Systemen beschäftigt, ist ein Teilbereich der angewandten Ethik. Dieser widmet sich Fragen, die durch die Entwicklung, Einführung und Nutzung von KI-basierten Systemen für das Handeln der Individuen in der Gesellschaft sowie für die moralischen Normen einer Gesellschaft aufgeworfen werden. Das Hauptaugenmerk liegt dabei also allen voran auf der Frage, inwiefern KI-basierte Systeme das Leben von Einzelpersonen verbessern können bzw. welche Bedenken dabei aufgeworfen werden.

Solche Anwendungen der Künstlichen Intelligenz, die auf Verfahren des maschinellen Lernens basieren, haben einerseits das Potential, Entscheidungswege effizient zu gestalten. Andererseits können sie jedoch auch erheblichen Schaden anrichten. In diesem Kontext liegt ein Schaden dann vor, wenn eine Vorhersage oder ein Ergebnis eines KI-Systems die Fähigkeit eines Individuums, seine rechtmäßige Persönlichkeit zu etablieren, negativ beeinflusst und dies im Endeffekt dazu führt, dass seine Fähigkeiten, auf Ressourcen zuzugreifen, beeinflusst oder beeinträchtigt werden.

KI und Ethik - Das Problem sitzt vor dem Computer

„Verantwortlich für das Versagen der Algorithmen sind wir Menschen.“ [1]

Bereits seit einigen Jahren nimmt KI nach und nach immer mehr Einfluss auf unseren Alltag. Kleine Alltagshelfer wie sprachgesteuerte Assistenten, Übersetzer und Chatbots erweisen sich meist als äußerst nützlich und sind einfach zu handhaben. Sie übernehmen dabei klar definierte Aufgaben und greifen auf das zurück, was der Mensch ihnen beigebracht hat. Ihre KI arbeitet mithilfe von Verfahren wie Machine- und Deep Learning. Die Programme durchforsten also riesige Datenmengen und erkennen darin Muster. Anhand dieser Muster lernen sie dann weiter.

Doch genau hier liegt das Problem: Bei der Auswertung solch großer Datenmengen reproduziert die KI, was sie aus eben diesen entnehmen kann. Die Folge davon können unfaire Systeme sein.

Inwiefern kann eine KI unfair agieren? Ein großes Unternehmen beispielsweise verwendete zur Vorsortierung von Bewerbungen eine entsprechende KI. Die Software wurde jedoch auf Grundlage einer eingeschränkten Datenbasis programmiert. Die verwendeten Daten stammten aus den vergangenen zehn Jahren, in denen überwiegend männliche Bewerber eingestellt wurden. Dementsprechend hat der Algorithmus gelernt, dass die Eigenschaft „männlich“ positiv zu bewerten ist. Als Konsequenz davon wurden Frauen im Vergleich zu Männern von der KI schlechter bewertet.

Besonders gefürchtet sind solch diskriminierende Algorithmen in der Medizin – schließlich geht es dabei mitunter um Leben und Tod. Eine Künstliche Intelligenz durchforstet zwar schneller als jeder Mensch tausende Studien aus wissenschaftlichen Zeitschriften und erstellt entsprechende Vorschläge für eine Diagnose, aber auch ein Algorithmus macht Fehler. Zudem sind manche Krankheiten gar nicht in Form von Forschungsdaten erfasst. Dies macht deutlich, dass Algorithmen, die auf solchen Datensätzen beruhen, gar nicht ausgewogen sein können. Es stellt sich nun wiederum in Bezug auf die Ethik die Frage, wie man damit umgeht und wer dafür verantwortlich ist.

An dieser Stelle möchten wir auf das oben angebrachte Zitat verweisen. Es stammt von den Autoren des Buches „Wir und die intelligenten Maschinen“, Jörg Dräger und Ralph Müller-Eiselt, die weiterhin dazu anbringen:

„Wir definieren ihre Ziele, programmieren ihren Code, entscheiden über ihren Einsatz. Deshalb sollten wir auch ihre Wirkung kontrollieren. Das erfordert mehr algorithmische Kompetenz und mehr ethische Verantwortung.“ [2].

Wie diskriminierend ist KI nun wirklich?

Das Maschinelle Lernen beruht auf einer Klassifizierung: Die Systeme erkennen neue Muster in Daten und weisen Ergebnisse bestimmten Gruppen zu. Wann wird eine solche Entscheidung also diskriminierend? Allgemein gesagt, gilt etwas als diskriminierend, wenn Gleiches ungleich oder Ungleiches gleich behandelt wird. Das Problem ist dabei nicht die Differenzierung an sich, sondern ob eine solche Ungleichbehandlung gerechtfertigt ist oder nicht. Dies lässt sich jedoch nicht objektiv definieren.

Die aufgrund von diskriminierenden KI-Systemen entstandenen Verzerrungen bezeichnet man als „Biases“. Sie entstehen sowohl bei der Konzipierung (Input) von Künstlicher Intelligenz als auch bei ihrer Anwendung (Output). Eine solche Diskriminierung bei der Eingabe liegt vor, wenn gesellschaftlich etablierte Vorurteile in die Software übertragen werden. Dies kann explizit geschehen, indem diskriminierende Unterscheidungen programmiert werden. Beispielsweise wenn Sensoren aufgrund technischer Vorgaben nur bei heller Hautfarbe reagieren. Andere implizite Diskriminierungsformen entstehen erst in der Anwendung und zeigen sich dementsprechend auch erst in dem jeweiligen Moment wie bei dem Chatroboter „Tay“, der von Google entwickelt wurde und aufgrund systematischer, fremdenfeindlicher Konversationen eine diskriminierende Ausdrucksweise entwickelte.

In einem Beitrag für das Wissenschaftsjahr fasst Susanne Beck, Professorin für Strafrecht, Strafprozessrecht, Strafrechtsvergleichung und Rechtsphilosophie an der Universität Hannover, die Problematik zusammen:

KI-Diskriminierung und Genderfragen

Hast Du dich bereits einmal gefragt, warum Stimmen von KI-Assistenzsystemen wie Alexa, Siri oder diversen Navigationssoftwares weiblich sind? All diese Systeme weisen geteilte Eigenschaften auf: Sie sind hilfsbereit, unterstützend, vertrauenswürdig, verlässlich kompetent, effizient, geduldig und anspruchslos. Und obwohl Alexa beispielsweise den ganzen Tag mit uns spricht, hat sie dennoch nicht das Sagen. Natürlich lässt sich die voreingestellte Frauenstimme oftmals verändern. Trotzdem ist sie ein Ausdruck einer gesellschaftlichen Voreinstellung, anhand derer die Systeme in unseren Alltag integriert werden. Bereits 2005 beschrieben Clifford Nass und Scott Brave, dass weibliche Stimmen in der Mensch-Computer-Interaktion Hilfe suggerieren, um Probleme selbst zu lösen. Männliche Stimmen hingegen suggerieren, uns Lösungen bereitzustellen.

Kaum zu glauben, aber in den 50er und 60er Jahren des vergangenen Jahrhunderts war das Programmieren als sekundäre Aufgabe Frauenarbeit. Die Begründung dafür lautete sinngemäß, dass Frauen ja schließlich auch in der Lage sind, Strickmuster zu entwerfen. Den hauptsächlich männlichen Herstellern der Maschinen hingegen galten Ruhm und Ehre. Heute gibt es jedoch auffallend wenig Frauen, die in diesem Bereich tätig sind und das, obwohl viele ihrer Vorgängerinnen Grundsteine für die heutige Informatik gelegt haben. Der Global Gender Gap Report des World Economic Forum, der im Dezember 2018 veröffentlich wurde, zeigt, dass die Erfolge der Geschlechtergerechtigkeit in zentralen gesellschaftlichen Bereichen aufgrund von KI erneut in Frage stehen. Demnach sind 78 Prozent derjenigen, die im KI-Sektor arbeiten (vorwiegend weiße) Männer. Der Gender Gap ist damit dreimal so hoch wie in anderen Industrien. Zudem werden Frauen im KI-Bereich oftmals schlechter bezahlt und in reputationsarmen Bereichen eingesetzt. Da der Gender-Gap so groß ist, wird er sich, laut dem World Economic Forum, auch nicht von selbst aufheben.

Es zeigt sich also, dass KI-Systeme in vielen Fällen die Gesellschaft mitsamt den bestehenden Ungerechtigkeiten abbilden. Wenn mithilfe von KI-Berechnungen Kredite vergeben, Studienplätze verteilt und Entscheidungen über vorzeitige Haftentlassungen getroffen werden, können historische bzw. verzerrte Daten zu Ungerechtigkeit führen. Eine Forderung nach der radikalen Erhöhung des Frauenanteils bezogen auf die ökonomische Teilhabe ist dringend nötig, reicht aber nicht aus, um die bestehenden Probleme rund um den „pale male mainstream“ zu beseitigen. Der Grund dafür ist, dass Diskriminierungsfragen intersektionell sind. Das heißt, dass Diskriminierungskategorien wie Geschlecht, Rasse, Klasse oder Herkunft miteinander verbunden sind und nicht ausschließlich einzeln betrachtet werden können. In diesem Zusammenhang wird eine entsprechende Aus- und Weiterbildung benötigt, die gesellschaftliche Kontexte reflektiert und ein Wissen über mögliche Diskriminierungsformen vermittelt. Es braucht also eine Professionsethik, die die ethischen Grundlagen der eigenen Arbeit thematisiert.

Eine Zusammenfassung und weitere Anregungen zu KI-Diskriminierung bezogen auf Genderfragen findet Ihr in diesem Interview mit Prof. Dr. Katharina Simbeck von der HTW Berlin:

Eine gesellschaftsverträgliche KI gestalten

„Gesellschaftsverträgliche KI-Systeme sollten das gesamte Spektrum der menschlichen Fähigkeiten und Anforderungen berücksichtigen.“ [3]

Bereits 2016 reagierte die Politik und so setzte der damalige Bundesverkehrsminister Alexander Dobrindt eine Kommission ein, die 20 ethische Regeln entwickelte, welche weltweit die ersten Leitlinien für Fahrcomputer darstellen. Aus ihnen geht hervor, dass grundsätzlich die höchstmögliche Anzahl an Leben geschützt werden soll, da der Wert eines jeden einzelnen Menschen aus ethischer Perspektive unantastbar bleibt. Weiterhin soll die Software selbstfahrender Autos blind gegenüber bestimmter Merkmale sein, um somit Diskriminierung vorzubeugen. Auf diese Ethik-Kommission folgte die Datenethik-Kommission, die den Einsatz von Algorithmen in ganz konkreten Situationen hinterfragt hat. Darüber hinaus hat die EU-Kommission eine Expertengruppe zur Ethik von KI und Algorithmen eingesetzt, die im Juni 2019 diesbezüglich Ratschläge für die Politik zusammenfasste.

Eine erste wichtige Forderung dieser KI Strategie ist dabei, menschliche Handlungsfähigkeit und Aufsicht bei der Umsetzung von KI-Systemen zu erhalten. KI-Systeme sollen schließlich gerechte Gesellschaften ermöglichen, indem sie die menschliche Handlungsfähigkeit sowie Grundrechte unterstützen. Eine wichtige Rolle kommt dabei Werten wie Transparenz und Informationsautonomie zu. Weiterhin zählt zu den Voraussetzungen für ein vertrauenswürdiges KI-basiertes System, dass Algorithmen sicher, zuverlässig und robust genug sind, um Fehler oder Inkonsistenz während aller Phasen zu vermeiden. Darüber hinaus spielt in diesem Zusammenhang der Schutz von generierten Daten eine große Rolle. Die Anwendenden sollte eine möglichst große Kontrolle über ihre eigenen Daten haben und zudem die Gewissheit, dass die betreffenden Daten nicht gegen sie verwendet werden können. Zusammenfassend sollen KI-Systeme das gesamte Spektrum der menschlichen Fähigkeiten und Anforderungen berücksichtigen, den barrierefreien Zugang zu Ressourcen und Möglichkeiten gewährleisten sowie die Rückverfolgung von Ergebnissen und Entscheidungen erlauben. Auch der Aspekt der Nachhaltigkeit sowie die ökologischen Auswirkungen von Algorithmen und Co. müssen im Zusammenhang mit der Digitalisierung durch KI Beachtung finden. Nicht zuletzt müssen Mechanismen geschaffen werden, die es erlauben, Verantwortung und Rechenschaftspflicht für KI-Systeme und deren Ergebnisse zu gewährleisten.

Mögliche Grundsätze für eine ethische KI

Die UNI Global Union formulierte bereits 2017 10 Grundsätze, die Gewerkschaften, Vertrauensleuten und Beschäftigten ein Bündel konkreter Forderungen in Bezug auf Transparenz und die Anwendung von KI an die Hand geben. Sie informieren KI-Programmierer und Geschäftsleitungen darüber, wie wichtig es ist, die Arbeitnehmer einzubeziehen. Um die Interessen der Arbeitnehmer zu wahren und ein ausgewogenes Kräfteverhältnis am Arbeitsplatz aufrechtzuerhalten, sollen die Grundsätze aktiv von Betrieben anerkannt und umgesetzt werden. Es handelt sich dabei um die folgenden 10 Grundsätze bezogen auf KI und Ethik:

Bei einem solchen System ist es möglich, zu erkennen, wie und warum eben dieses eine bestimmte Entscheidung getroffen hat oder warum ein Roboter beispielsweise in einer bestimmten Weise gehandelt hat. Dieser Grundsatz ist von großer Bedeutung, da er sicherstellt, dass die übrigen Grundsätze eingehalten werden können.

Die sogenannte „Ethik-Black-Box“ ist dazu da, Informationen über das KI-System aufzuzeichnen und somit dessen vollständige Transparenz zu gewährleisten. Darüber hinaus sollte diese Box Daten und Informationen über in das KI-System eingebaute ethische Überlegungen bereitstellen können. Bezogen auf einen Roboter würde die Black Box alle Entscheidungen, die Grundlagen für die Entscheidungsfindung sowie sensorische Daten aufzeichnen. Die von der Black Box gelieferten Daten könnten wiederum den Roboter dabei unterstützen, sein Handeln in einer für Menschen verständlichen Sprache zu erklären, was sowohl eine bessere Beziehung fördert als auch die Benutzerfreundlichkeit verbessert.

Dies umfasst einerseits Ethikcodes für die Entwicklung, Anwendung und Nutzung von KI, in dem Sinne, dass KI-Systeme über ihren gesamten operativen Prozess hinweg kompatibel bleiben und den Grundsätzen menschlicher Würde, Integrität, Freiheit, Privatsphäre und kultureller bzw. geschlechtsspezifischer Vielfalt sowie grundlegende Menschenrechte fördern. Außerdem müssen KI-Systeme die Ökosysteme und die biologische Vielfalt unseres Planeten schützen, wenn nicht sogar verbessern.

Damit Maschinen den rechtlichen Status von Werkzeugen besitzen und Menschen jederzeit die Kontrolle über- sowie die Verantwortung für diese Maschinen behalten, ist eine unabdingbare Voraussetzung, dass die Entwicklung von KI verantwortungsbewusst, sicher und nützlich sein muss. Damit einher geht, dass KI-Systeme so konzipiert und betreiben werden sollten, dass sie in Einklang mit bestehenden Rechtsvorschriften stehen. Die Menschen müssen Recht auf den Zugriff, die Verwaltung sowie die Kontrolle der von KI-Systemen erzeugten Daten haben, da diese die Fähigkeiten besitzen, die Daten zu analysieren und zu verwenden.

Bei der Gestaltung und Wartung von KI ist es von großer Bedeutung, dass das System im Hinblick auf negative oder schädliche menschliche Vorurteile hin kontrolliert- und jegliche Voreingenommenheit erkannt- bzw. nicht vom System weiterverbreitet wird.

Die KI-Technologien sollten möglichst vielen Menschen einen Nutzen bringen. Der von KI geschaffene wirtschaftliche Wohlstand sollte dementsprechend breitflächig und gleichmäßig verteilt werden, sodass die gesamte Menschheit davon profitieren kann. Aus diesem Grund werden globale sowie nationale und politische Strategien zur Schließung der existierenden wirtschaftlichen, technologischen und gesellschaftlichen Kluft benötigt.

Grundlegend wichtig ist es, politische Strategien einzusetzen, die einen gerechten Übergang in die digitale Welt sicherstellen. Dies erfordert, dass Arbeitnehmer auf allen Ebenen und in allen Beschäftigungskategorien Zugang zu sozialer Sicherheit sowie kontinuierlichem lebenslangem Lernen haben, um beschäftigungsfähig zu bleiben. Zusätzlich dazu müssen alle Arbeitnehmer in sämtlichen Beschäftigungsformen dieselben starken Grundrechte habe. Dementsprechend müssen alle KI-Systeme mit einer Kontrolle und einem Abwägen diesbezüglich einhergehen. Dazu könnte ein spezieller, im System eingebauter Algorithmus dienen.

Für menschwürdige Arbeit und ethische KI auf globaler und regionaler Ebene wird der Einsatz von Vertreter*innen mehrerer Interessengruppen bestehender Governance-Gremien empfohlen. Darüber hinaus müssen Whistleblowing-Mechanismen und Verfahren eingesetzt werden, um den Übergang und die Umsetzung von ethischer KI sicherzustellen.

Grundsätzlich gilt, dass Roboter so entwickelt und betrieben werden sollen, dass sie die bestehenden Gesetze und Grundrechte- sowie freiheiten einhalten. Damit verbunden ist die Frage nach der rechtlichen Verantwortung. In diesem Zusammenhang sollen Personen mit rechtlicher Zuständigkeit einem Roboter zugewiesen werden. Roboter sind demnach nach dem Gesetz keine verantwortlichen Parteien.

Um KI in Gesellschaft und Alltag vollständig zu integrieren, braucht es Gestaltungsregeln, an denen sich die Entwicklung und der Einsatz algorithmischer Systeme orientieren kann. Im Projekt „Ethik der Algorithmen“ hat die Bertelsmann Stiftung gemeinsam mit dem Think Tank iRights.Lab sowie mit zahlreichen weiteren Expert*innen die sogenannten „Algo.Rules“ erarbeitet. Dabei handelt es sich um einen Katalog von neun Regeln, die beachten werden müssen, um eine gesellschaftlich förderliche Gestaltung sowie den entsprechenden Einsatz algorithmischer Systeme zu ermöglichen und zu erleichtern. Diese Regeln sollten bereits bei der Entwicklung von KI-Systemen beachtet und implementiert werden. Vor allem Entwickler*inne, Designer*innen und Programmierer*innen, die einen signifikanten Einfluss auf die Entwicklung und den Einsatz algorithmischer Systeme haben, kommt dabei eine besondere Bedeutung zu.

Diejenigen, die algorithmische Systeme entwickeln, betreiben oder über ihren Einsatz entscheiden, müssen auf Grundlage ihrer erforderlichen Fachkompetenzen die Funktionsweise sowie die möglichen Auswirkungen eben dieser verstehen. Dafür sind das Teilen von individuellem bzw. institutionellem Wissen sowie der interdisziplinäre Austausch zwischen den Aufgabenbereichen zentral – ebenso wie qualifizierende Maßnahmen. Diese gilt es, in die Ausbildung neuer Mitarbeiter*innen zu integrieren. Weiterhin sollte der interdisziplinäre Austausch verfestigt werden und für andere Interessierte offenstehen.

Die Frage nach Verantwortung bedarf einer eindeutigen Zuteilung. Der zuständigen Person müssen in diesem Zusammenhang die damit verbundenen Aufgaben bewusst sein. Dies gilt natürlich auch für geteilte Verantwortlichkeiten bei mehreren Personen bzw. Organisationen. Die Zuteilung wiederum muss entsprechend lückenlos sowie transparent dokumentiert werden. Allgemein darf die Verantwortung weder auf das algorithmische System noch auf Anwender*innen oder betroffene Personen abgewälzt werden.

Die Ziele eines algorithmischen Systems müssen klar definiert sein. Hinzukommt, dass die Informationen zu dessen Einsatz dokumentiert werden müssen. Dazu zählen beispielsweise zugrundliegende Daten und Berechnungsmodelle. Eine dokumentierte Folgenabschätzung ist vor dem Einsatz des KI-Systems durchzuführen. Diese muss weiterhin insbesondere bei lernenden Systemen und in dynamischen Einsatzfeldern mit viel Veränderung in regelmäßigen Abständen widerholt werden. Dabei sind allen voran die Risiken für Diskriminierung sowie weitere für das Individuum und das Gemeinwohl bedeutende Folgen im Blick zu behalten. Auch Werteabwägungen bei der Zielsetzung und dem Einsatz algorithmischer Systeme müssen festgehalten werden.

Die Zuverlässigkeit und Robustheit eines KI-Systems sowie der zugrundeliegenden Daten gegenüber Angriffen, Zugriffen und Manipulationen sind unbedingt zu gewährleisten. Um dies zu erreichen, muss Sicherheit von Beginn an ein festes Element der Gestaltung des algorithmischen Systems sein. Darüber hinaus ist das System vor seinem Einsatz in einer geschützten Umgebung zu testen. Weiterhin müssen die getroffenen Sicherheitsvorkehrungen dokumentiert werden.

Für Personen die mit algorithmischen Systemen interagieren, muss bei ihrem Einsatz durch eine entsprechende Kennzeichnung erkennbar sein, dass der Entscheidung oder Prognose eine KI-System zugrunde liegt. Dies gilt besonders dann. Wenn das System einen Menschen bzw. seine Interaktion imitiert.

KI-Systeme müssen in ihrer Wirkung sowie Funktionsweise für Menschen möglichst leicht verständlich gemacht werden. Dazu müssen Informationen über die den Systemen zugrunde liegenden Daten und Modell in leicht verständlicher Sprache dargestellt werden.

Um zu gewährleisten, dass ein algorithmisches System beherrschbar bleibt, müssen alle daran beteiligten Personen gemeinsam stets die Kontrolle über eben dieses behalten. Es muss sichergestellt werden, dass der Gesamtüberblick über das System stets gewahrt bleibt. Die Arbeitsweise eines Systems darf also niemals so komplex und undurchschaubar werden, dass es von Menschen nicht mehr beherrschbar ist oder geändert werden kann. Dies gilt insbesondere für selbstlernende Systeme.

Ob die beabsichtigen Ziele eines KI Systems tatsächlich verfolgt werden und ob sein Einsatz möglicherweise bestehendes Recht verletzt, muss stets einer aktiven Kontrolle unterliegen. Dazu sollten externe Prüfstellen in die Lage versetzt werden, ein algorithmisches System tatsächlich und umfassend unabhängig prüfen zu können. Wird dabei eine negative Wirkung festgestellt, muss die Fehlerursache ermittelt und das KI-Systeme entsprechend angepasst werden.

Wir ein algorithmisches System eingesetzt, müssen leicht zugängliche Wege zur Kontaktaufnahme zur Verfügung stehen. Erstens müssen betroffene Personen eine qualifizierte und detaillierte Auskunft zur konkreten Entscheidung und der dahinter liegenden Abwägung einfordern können. Darüber hinaus muss zweitens eine einfache, niedrigschwellige und wirksame Beschwerdemöglichkeit zur Verfügung stehen. Die Beschwerden und eigeleiteten Maßnahmen sind entsprechend zu dokumentieren.

Ethische Prinzipien messbar machen

Wie Ihr seht, gibt es eine Vielzahl an Leitlinien für die ethische Gestaltung von KI durch Akteure aus Wirtschaft, Zivilgesellschaft, Wissenschaft und Politik. Offen bleibt jedoch die Frage, wie die darin enthaltenen Prinzipien konkret umgesetzt werden sollen. Da es viele unterschiedliche Verständnisse für Begriffe wie Transparenz und Gerechtigkeit gibt, fehlt KI-entwickelnden Unternehmen die nötige Orientierung sowie eine wirksame Kontrolle der algorithmischen Systeme. Darin besteht aktuell eines der größten Hindernisse für die Entwicklung gemeinwohlorientierter Künstlicher Intelligenz. Daher hat die Bertelsmann Stiftung gemeinsam mit der gemeinnützigen Normierungsorganisation VDE ein Arbeitspapier mit dem Titel „AI Ethics: Form Principles to Practice – An interdisciplinary framework to operationalise AI“ entwickelt, welches erklärt, wie KI-Ethikprinzipien europaweit operationalisiert und in die Praxis überführt werden können.

Zentrales Element des Papiers ist der Vorschlag eines Ethik-Labels für KI-Systeme. Ein solches Label bietet – vergleichbar mit einem Energieeffizienzlabel für Elektrogeräte – KI-entwickelnden Organisationen die Möglichkeit, die Qualität ihrer Produkte nach außen zu kommunizieren. Damit macht das Label die auf dem Markt zur Verfügung stehenden Produkte für Konsumenten und KI-einsetzende Organisationen besser vergleichbar und schafft einen schnellen Überblick darüber, ob ein algorithmisches System die im Anwendungsfall nötigen ethischen Anforderungen erfüllt. Somit kann über rechtlich vorgegebene Grenzen hinaus eine ethische Entwicklung von KI gefördert werden.

Quelle: Hustedt, Carla/Fetic, Lajla: From principles to practice: Wie wir KI-Ethik messbar machen können. Algorithmenethik 2020 (https://algorithmenethik.de/2020/04/02/from-principles-to-practice-wie-wir-ki-ethik-messbar-machen-koennen/).

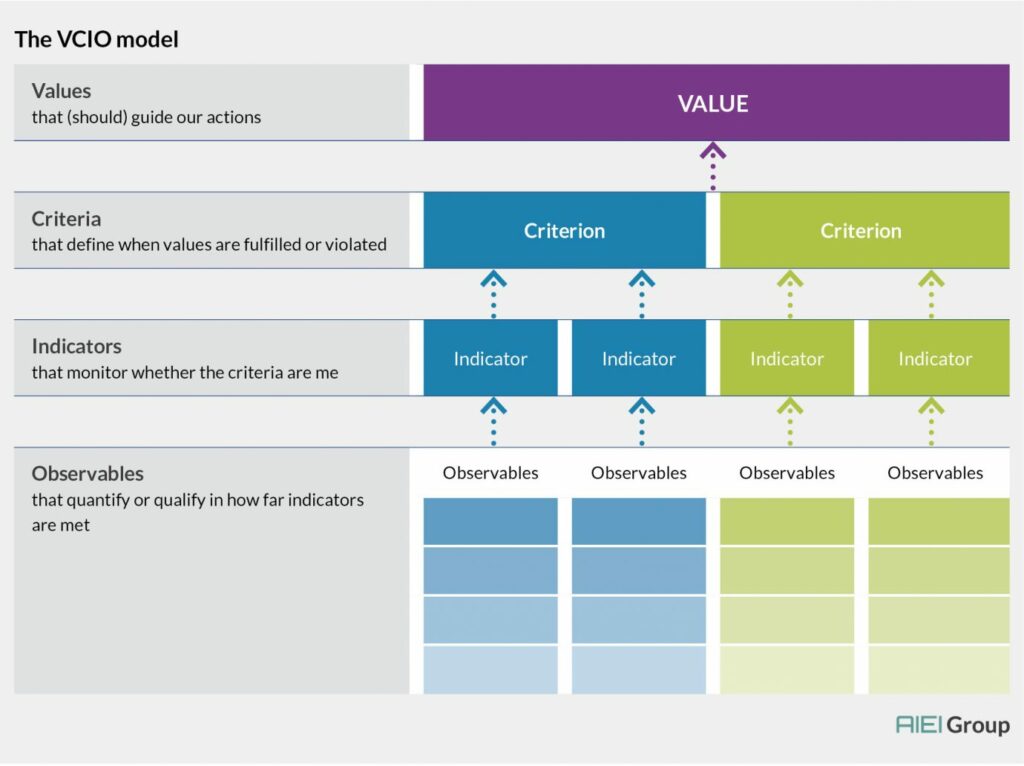

Welche Anforderungen zum Erreichen einer bestimmten Stufe notwendig sind, kann wiederum vorab mithilfe des sogenannten „WKIO-Modells“ bestimmt werden. Dieses Modell bietet die methodische Basis für den Vorschlag des Arbeitspapiers und kann dabei helfen, allgemeine Werte durch die Aufschlüsselung in Kriterien, Indikatoren und messbare Observablen zu konkretisieren, um somit deren Umsetzung überprüfbar zu machen.

Quelle: Hustedt, Carla/Fetic, Lajla: From principles to practice: Wie wir KI-Ethik messbar machen können. Algorithmenethik 2020 (https://algorithmenethik.de/2020/04/02/from-principles-to-practice-wie-wir-ki-ethik-messbar-machen-koennen/).

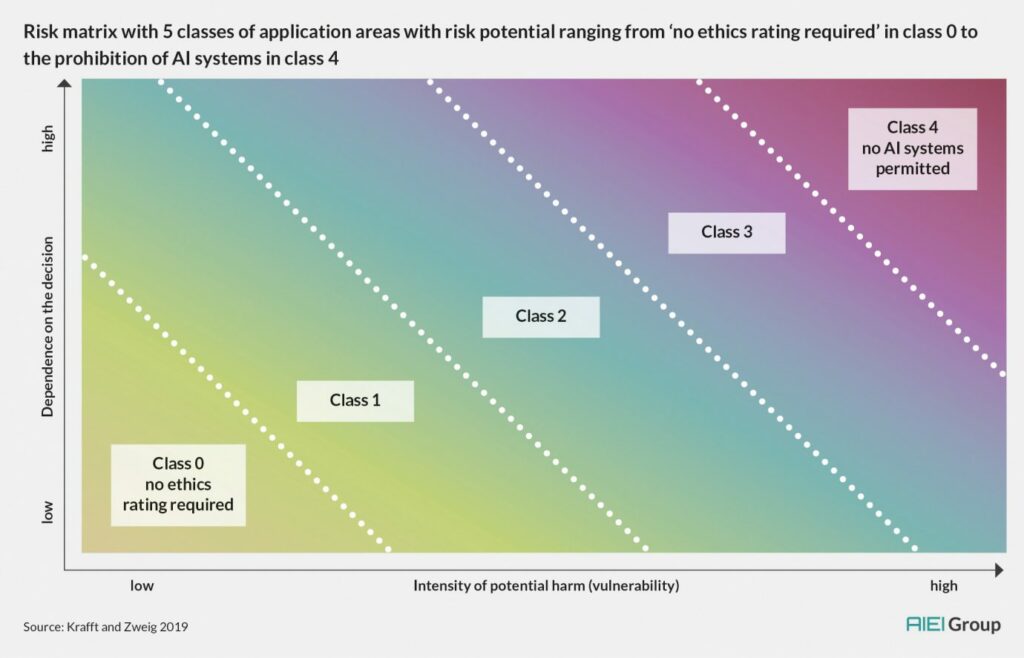

Zur Klassifizierung verschiedener Anwendungskontexte stellt das Arbeitspapier die „Risko-Matrix“ vor. Diese nutzt einen zweidimensionalen Ansatz, um der gegebenen Vielfalt verschiedener Anwendungsfälle gerecht zu werden. Als Dimensionen für die Klassifizierung besitzt die Matrix die Intensität des potenziellen Schadens (X-Achse) sowie die Abhängigkeit der betroffenen Personen von der jeweiligen Entscheidung (Y-Achse). Die Intensität des potenziellen Schadens berücksichtigt das Ausmaß der Verletzung von individuellen Grundrechten, die Anzahl der betroffenen Personen sowie mögliche negative Auswirkungen auf die Gesellschaft als Ganzes. Die Abhängig der betroffenen Personen hängt unter anderem von der Möglichkeit ab, sich der Entscheidung entziehen-, ein anderes System wählen- oder eine bestehende Entscheidung hinterfragen zu können.

Quelle: Hustedt, Carla/Fetic, Lajla: From principles to practice: Wie wir KI-Ethik messbar machen können. Algorithmenethik 2020 (https://algorithmenethik.de/2020/04/02/from-principles-to-practice-wie-wir-ki-ethik-messbar-machen-koennen/).

Fazit

Wie der vorliegende Beitrag gezeigt hat, ist es notwendig, Diskriminierungsprozesse verursacht durch KI zu erkennen und ihnen in ihren komplexen gesellschaftlichen Erscheinungsformen zu begegnen. Für Gerechtigkeitsfragen sind nicht allein diejenigen zuständig, die jeweils diskriminiert werden, sondern alle Mitglieder der Gesellschaft. Auch wenn Individuen grundsätzlich gegen eine unrechtmäßige Diskriminierung durch KI-Systeme vorgehen können sollen. Natürlich spielen dabei in einer digitalen Gesellschaft auch technische Instrumente eine Rolle. Alle diejenigen, die an und mit KI-Systemen arbeiten kommt in diesem Zusammenhang die Aufgabe zu, die Technik im Sinne des Gemeinwohls zu entwickeln und zu nutzen. Schulungen und Weiterbildungen für Beschäftigte, die KI nutzen, wären durchaus denkbar.

Zuletzt bleibt festzuhalten, dass die potenzielle Diskriminierung beim Einsatz von Künstlicher Intelligenz Teil einer größeren Debatte werden muss. Die Frage, wie man allen Menschen gleichermaßen im digitalen Zeitalter ein gutes Leben ermöglichen kann, sollte im Mittelpunkt aller Anstrengungen und Debatten rund um das Thema KI stehen. Trotz aller moralischer Dilemmata ist in diesem Zusammenhang zu bedenken: Keine Künstliche Intelligenz einzusetzen, ist auch keine Lösung.

[1] Zit. Dräger, Jörg/Müller-Eiselt, Ralph: Wir sind die intelligenten Maschinen. In Zeit: Kethik. KI braucht Ethik. (https://www.zeit.de/angebote/weltderdaten/kuenstliche-intelligenz-und-ethik/index).

[2] Zit. Dräger, Jörg/Müller-Eiselt, Ralph: Wir sind die intelligenten Maschinen. In Zeit: Kethik. KI braucht Ethik. (https://www.zeit.de/angebote/weltderdaten/kuenstliche-intelligenz-und-ethik/index).

[3] Zit. Zuckerberg, Mark: Indipendent: Zuckerberg hearing: Facebook founder attacked by US politicians for site’s ‚bias‘ and failure to protect users – as it happened. In Levina, Olga: Ethik und Künstliche Intelligenz. Ethische Fragestellungen der Gestaltung und Anwendung von KI-basierten Systemen. Informatik aktuell 2020 (https://www.informatik-aktuell.de/betrieb/kuenstliche-intelligenz/kuenstliche-intelligenz-und-ethik.html)

- https://www.youtube.com/watch?v=BaiB3f5oNVU

- https://www.zeit.de/angebote/weltderdaten/kuenstliche-intelligenz-und-ethik/index

- https://www.wissenschaftsjahr.de/2019/neues-aus-der-wissenschaft/das-sagt-die-wissenschaft/ki-genderfragen-und-diskriminierungen/

- https://www.wissenschaftsjahr.de/2019/neues-aus-der-wissenschaft/das-sagt-die-wissenschaft/wie-diskriminierend-ist-kuenstliche-intelligenz/

- https://hochschulforumdigitalisierung.de/de/blog/diskriminierung-durch-algorithmen

- https://www.plattform-lernende-systeme.de/files/Downloads/Publikationen/AG3_Whitepaper_250619.pdf

- https://www.informatik-aktuell.de/betrieb/kuenstliche-intelligenz/kuenstliche-intelligenz-und-ethik.html

- http://www.thefutureworldofwork.org/media/35484/uni-global-union_-kuenstliche-intelligenz.pdf

- https://www.bertelsmann-stiftung.de/fileadmin/files/alg/Algo.Rules_Praxisleitfaden.pdf

- https://algorithmenethik.de/2020/04/02/from-principles-to-practice-wie-wir-ki-ethik-messbar-machen-koennen/